Seit Jahrzehnten arbeiten Neurologen daran, anhand der Auswertung der Alpha-, Beta-, Delta-, Gamma- und Thetawellen von Hirnströmen Abläufe in unserem zentralen Denkorgan zu interpretieren. So gelang es z. B. auf diese Weise 2012 Forschenden der Berkeley University of California, einzelne von Testpersonen gehörte Wörter aus Hirnströmen zu rekonstruieren. Mehr als ein Dutzend Epilepsie- bzw. Tumor-Patienten wurden operiert und hierbei konnten die Wissenschaftler bei ihnen Elektroden direkt an der Hirnrinde anbringen. Während den Patienten verschiedenste Wörter vorgelesen wurden, wandelte der Computeralgoritmus einer Künstlichen Intelligenz (KI) die Gehirnsignale in Schallmuster um. Daraus erzeugte die KI wiederum Laute, aus denen die entsprechenden Wörter wieder zu erkennen waren.

Wenige Jahre später testeten Forscherinnen und Forscher des Karlsruher Instituts für Technologie (KIT), eine Technische Universität des Landes Baden-Württemberg und nationales Forschungszentrum in der Helmholtz-Gemeinschaft, einen Computerverbund, der anhand von Gehirnwellem nicht nur einzelne Wörter, sondern ganze Sätze erkennen und wiedergeben konnte. Diesmal lasen sieben Epilepsie-Patienten, denen man Elektroden ins Gehirn implantiert hatte, zunächst laut Texte vor. Hierdurch lernte ein Algorithmus, welche Hirnwellen welchen Wörtern und Sätzen entsprachen. Als die Patienten später ihre Texte noch einmal vorlasen, konnte das Computersystem anhand der dabei gemessenen Hirnströme ganze Sätze korrekt schriftlich wiedergeben mit einer Wort-Fehlerrate von weniger als 25 Prozent.

Jetzt legen Forschungsergebnisse einer Gruppe von Wissenschaftlern um den britischen Gehirn-Computer-Schnittstellen-Experten Dr. Ian Daly von der School of Computer Science and Electronic Engineering der Uni Essex nahe, dass dort eine Methode entwickelt wurde, die mit Hilfe einer KI entschlüsselt, welchem Musikstück Testperson gerade lauschen. Dafür nutzte man die Daten einer früheren Studie, in der eigentlich die Gefühle der Musikhörer unter die Lupe genommen worden waren, wie das Wissensportal NATURE berichtet.

Dalys Probanden wurden 36 kurze Klavier-Stücke vorgespielt, währenddessen ihre Gehirnaktivitäten sowohl via Elektroenzephalografie (EEG) als auch mittels funktioneller Magnetresonanztomografie (fMRT) aufgezeichnet wurden. Dabei wurden die EEG-Ergebnisse ergänzt durch Messungen des Blutflusses im Gehirn, welche zeigen sollten, welche Hirnregionen beim Musikhören bei des jeweiligen Probanden besonders aktiv sind.

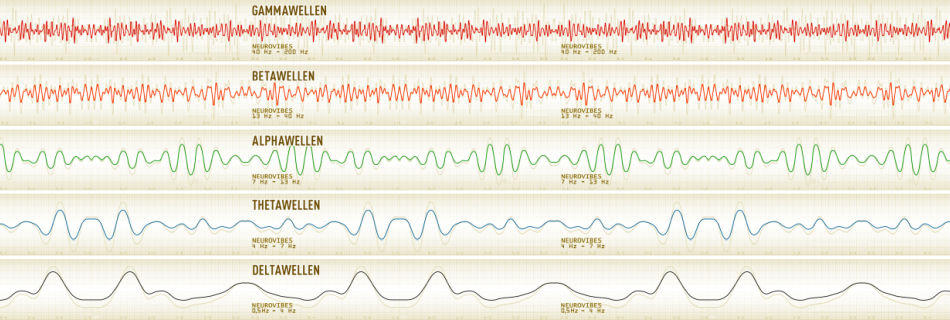

Eine Künstliche Intelligenz war hierbei von Dr. Dalys Team darauf trainiert worden, durch die Muster des EEG das Musikstück, welches die jeweilige Person während der Messung gehört hatte, nachzubilden. Hierfür wählte man genau die EEG-Daten aus, die mit besonderer Aktivität von Alpha-, Beta-, Delta-, Gamma- und Thetawellen (abzulesen an den fMRT-Daten) verknüpft waren. Die KI konnte dadurch eine große Ähnlichkeit zu den Originalsongs definieren und identifizierte mit einer Trefferquote von knapp 72 Prozent, welchen der 36 Songs die Person betreffende gehört hatte. Beeindruckend: Bei einer Kontrollgruppe von knapp 20 anderen Testpersonen lagen nur EEG-Daten vor. Hier erreichte die Künstliche Intelligenz ohne die fMRT-Verknüpfung nur eine Trefferquote von weniges als 60 Prozent.

Beeindruckend an den Untersuchungen der Forschenden der Univerität Exxex ist vor allem, dass sie gezeigt haben, dass man Gehirnwellen bis zu einem gewissen Grad entschlüsseln bzw. interpretieren kann, ohne mit Messinstrumenten ins menschliche Denkorgan einzudringen. Das dürfte besondern Tech-Konzerne wie google, Apple oder Meta interessieren, die seit langem daran arbeiten, Gedanken aus dem Kosmos in unserem Kopf zu entschlüsseln und zwar ohne implantierte Elektroden.